1 Introduction : Les Limites d’un Modèle Unique 🧠

En Machine Learning, nous avons une panoplie de modèles performants : arbres de décision, SVMs, régression logistique… Pourtant, se fier à un seul de ces “experts” peut être risqué. Un arbre de décision, par exemple, peut être très performant sur les données qu’il a vues, mais devenir instable et peu fiable si ces données changent un peu. Un modèle linéaire peut être très stable, mais trop simple pour capturer la complexité du monde réel.

Ce dilemme est au cœur d’un concept fondamental en statistiques : le compromis Biais-Variance.

1.1 Le Compromis Biais-Variance

L’erreur totale d’un modèle peut être décomposée en trois parties :

\[\text{Erreur Totale} = \text{Biais}^2 + \text{Variance} + \text{Erreur Irréductible}\]

Le Biais (\(Biais\)) : C’est l’erreur due à des hypothèses fondamentalement erronées dans le modèle. Un modèle avec un biais élevé (ex: un modèle linéaire pour un phénomène quadratique) “sous-apprend” (underfitting). Il simplifie trop la réalité. \(Biais(\hat{f}(x)) = E[\hat{f}(x)] - f(x)\)

La Variance (\(Variance\)) : C’est l’erreur due à la sensibilité du modèle aux petites fluctuations dans le jeu de données d’entraînement. Un modèle avec une variance élevée (ex: un arbre de décision très profond) “sur-apprend” (overfitting). Il mémorise le bruit au lieu du signal. \(Variance(\hat{f}(x)) = E[(\hat{f}(x) - E[\hat{f}(x)])^2]\)

L’Erreur Irréductible (\(\sigma^2\)) : C’est le bruit inhérent aux données elles-mêmes, qu’aucun modèle ne peut éliminer.

L’objectif est de trouver un équilibre. Malheureusement, réduire le biais a souvent pour effet d’augmenter la variance, et vice-versa. C’est là que les méthodes ensemblistes entrent en jeu, en offrant une solution élégante à ce compromis.

2 Le Principe Fondamental : La Diversité Annule les Erreurs 💡

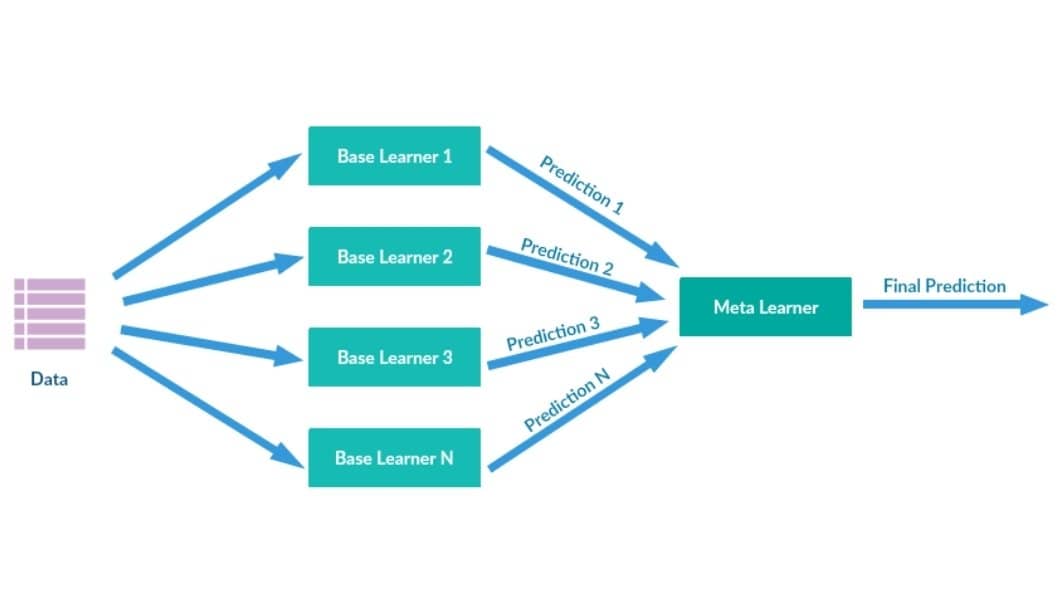

L’idée des méthodes ensemblistes est simple et puissante : plutôt que de chercher un unique super-modèle, on combine les prédictions d’un grand nombre de modèles plus simples pour obtenir une prédiction finale plus robuste et plus précise.

C’est le principe de la “sagesse de la foule”. Si vous posez une question complexe à un millier de personnes, la moyenne de leurs réponses sera souvent plus proche de la vérité que la réponse du meilleur expert du groupe.

Pour que cela fonctionne, une condition est essentielle : les modèles doivent être diversifiés. Ils ne doivent pas tous faire les mêmes erreurs. Si tous vos experts se trompent de la même manière, leur consensus sera tout aussi faux. Mathématiquement, on cherche des modèles dont les erreurs sont le moins corrélées possible.

3 Les Deux Grandes Stratégies Ensemblistes

Pour créer cette diversité et construire des ensembles efficaces, deux grandes familles de méthodes s’opposent.

3.1 Le Bagging (Approche Parallèle) 🌳🌳🌳

Le Bagging (pour Bootstrap Aggregating) vise principalement à réduire la variance.

La philosophie : On prend des modèles puissants mais instables (à forte variance), comme des arbres de décision profonds, et on les stabilise.

Le mécanisme :

- Bootstrap : On crée des dizaines ou des centaines de nouveaux jeux de données en échantillonnant avec remise à partir du jeu de données original. Chaque échantillon est légèrement différent, mais conserve les mêmes propriétés statistiques.

- Entraînement parallèle : On entraîne un modèle complet et indépendant sur chaque échantillon.

- Agrégation : Pour une nouvelle observation, on demande l’avis de chaque modèle et on agrège leurs prédictions (par un vote majoritaire en classification ou une moyenne en régression).

En moyennant les prédictions de tous ces modèles, on “lisse” les décisions extrêmes et on obtient un modèle final avec une variance beaucoup plus faible, sans pour autant augmenter le biais. Les Forêts Aléatoires (Random Forests) sont l’exemple le plus célèbre et le plus abouti de cette approche.

3.2 Le Boosting (Approche Séquentielle) 🚶♂️→🏃♂️→🚀

Le Boosting vise principalement à réduire le biais.

La philosophie : On part de modèles très simples, dits “faibles” (à fort biais), comme des arbres de décision de profondeur 1 ou 2, et on les combine pour créer un modèle final très puissant.

Le mécanisme :

- On entraîne un premier modèle faible sur les données.

- On identifie ses erreurs.

- On entraîne un deuxième modèle en lui demandant de se concentrer spécifiquement sur les observations que le premier a mal prédites (en leur donnant plus de poids).

- On répète ce processus séquentiel. Chaque nouveau modèle est un “spécialiste des erreurs” des modèles précédents.

La prédiction finale est une somme pondérée des prédictions de tous ces modèles. Le Boosting transforme une collection de modèles faibles en un “super-modèle” très performant. Les algorithmes comme Gradient Boosting, XGBoost ou LightGBM sont les stars de cette famille.

4 Un Bénéfice Inattendu : L’Importance des Variables (Feature Importance)

Même si les modèles ensemblistes sont souvent perçus comme des “boîtes noires”, les méthodes basées sur les arbres (comme les Forêts Aléatoires et le Gradient Boosting) offrent un avantage considérable : la mesure de l’importance des variables.

L’idée est de quantifier la contribution de chaque variable prédictive au modèle. Cela se fait en agrégeant la réduction d’impureté (comme l’indice de Gini ou l’entropie) apportée par une variable à chaque fois qu’elle est utilisée pour une division, sur l’ensemble des arbres de la forêt.

Cette mesure est extrêmement utile pour :

- Comprendre le modèle : Identifier les facteurs qui influencent le plus la prédiction.

- Faire de la sélection de variables : Éliminer les variables peu informatives pour simplifier le modèle.

- Communiquer les résultats : Expliquer à des non-spécialistes ce sur quoi le modèle base ses décisions.

5 Conclusion et Prochaines Étapes

Vous avez maintenant les bases théoriques de l’apprentissage ensembliste. Retenez ceci :

- Les ensembles combattent le compromis Biais-Variance en combinant de nombreux modèles.

- La diversité des modèles est la clé de leur succès.

- Le Bagging (ex: Forêts Aléatoires) réduit la variance en moyennant des modèles forts et indépendants.

- Le Boosting (ex: Gradient Boosting) réduit le biais en construisant une chaîne de modèles qui corrigent leurs erreurs mutuelles.

Dans notre prochain article, nous plongerons au cœur du mécanisme des Forêts Aléatoires pour comprendre en détail comment le hasard peut être orchestré pour créer des modèles d’une robustesse et d’une efficacité redoutables.